2024년 7월 17일

MathΣtral, Codestral Mamba

(Mistral AI)

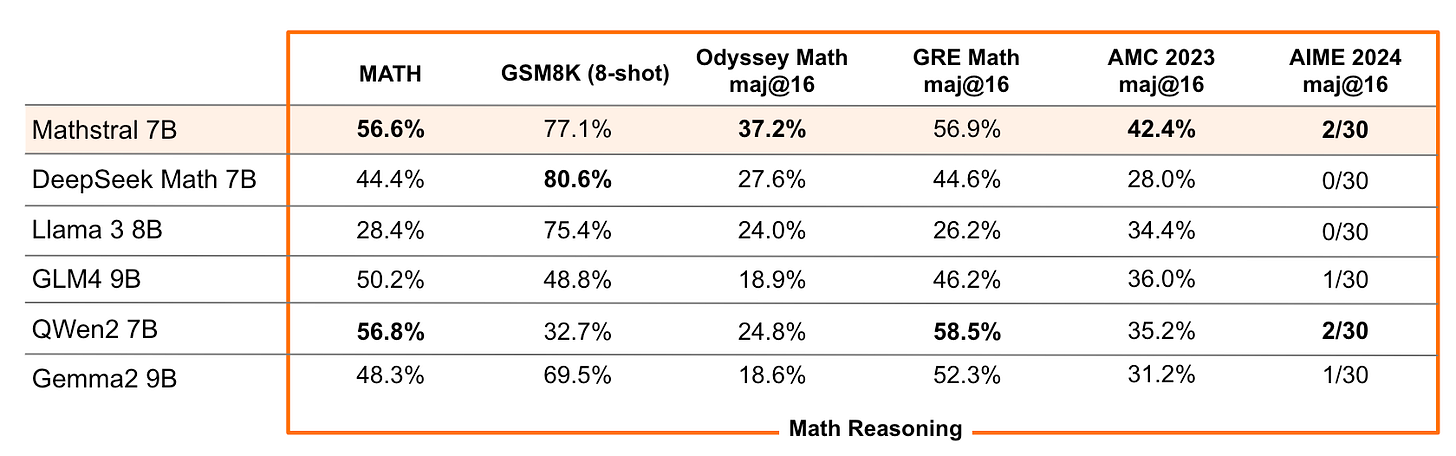

Mistral이 7B 수준에서 수학 모델 MathΣtral과 코드 모델 Codestral Mamba를 공개했네요. Mathstral은 DeepSeek Math 7B보다 벤치마크 스코어가 좋습니다. 어떤 데이터가 들어갔을지 테스트해보는 것도 재미있겠네요.

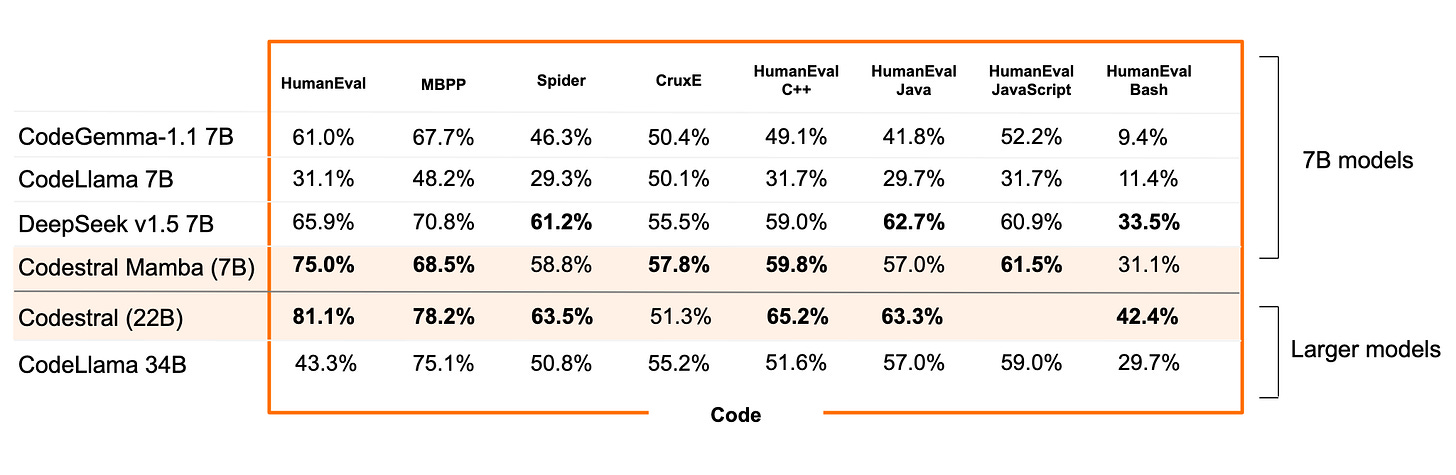

Codestral Mamba는 Mamba 2 기반 모형입니다. 전 Global Attention 없이 SSM 단독으로는 한계가 분명하리라고 생각하는데 사용 사례들이 나오면 좀 더 증거가 나오겠네요.

#llm

What happened to BERT & T5? On Transformer Encoders, PrefixLM and Denoising Objectives

(Yi Tay)

Yi Tay의 인코더와 Denoising에 대한 이야기. 인코더-디코더, 디코더, PrefixLM이 서로 그렇게 다른 것이 아니고 Denoising이나 Autoregressive LM은 어떤 구조에나 적용할 수 있다는 이야기, 모델이 커지면 이런 아키텍처의 차이는 크게 중요하지 않을 수 있다는 것, Denoising Objective를 사용하면 한 시퀀스에서 학습에 사용되는 토큰의 비율이 낮다는 것이 문제라는 통상적인 이야기를 합니다.

사실 가장 흥미로운 것은 Deonising Objective가 Autoregressive LM과 결합되었을 때 어떤 효과를 가질 것인가인데 장점이 있을 수 있다고 하긴 하지만 명확하게 이야기는 하지 않습니다. Yi Tay 본인은 무언가 알고 있을 수도 있겠지만 공개적으로 확실한 증거가 많이 있진 않긴 하죠. (FIM도 이런 Denosing Objective라고 생각해보면 사용해도 손해는 아니지만 특별히 성능이 나아지지도 않는다? 이런 느낌이기도 합니다.)

#llm

Scaling Diffusion Transformers to 16 Billion Parameters

(Zhengcong Fei, Mingyuan Fan, Changqian Yu, Debang Li, Junshi Huang)

In this paper, we present DiT-MoE, a sparse version of the diffusion Transformer, that is scalable and competitive with dense networks while exhibiting highly optimized inference. The DiT-MoE includes two simple designs: shared expert routing and expert-level balance loss, thereby capturing common knowledge and reducing redundancy among the different routed experts. When applied to conditional image generation, a deep analysis of experts specialization gains some interesting observations: (i) Expert selection shows preference with spatial position and denoising time step, while insensitive with different class-conditional information; (ii) As the MoE layers go deeper, the selection of experts gradually shifts from specific spacial position to dispersion and balance. (iii) Expert specialization tends to be more concentrated at the early time step and then gradually uniform after half. We attribute it to the diffusion process that first models the low-frequency spatial information and then high-frequency complex information. Based on the above guidance, a series of DiT-MoE experimentally achieves performance on par with dense networks yet requires much less computational load during inference. More encouragingly, we demonstrate the potential of DiT-MoE with synthesized image data, scaling diffusion model at a 16.5B parameter that attains a new SoTA FID-50K score of 1.80 in 512$\times$512 resolution settings. The project page: https://github.com/feizc/DiT-MoE.

Diffusion Transformer를 MoE를 사용해서 Scaling. DeepSeek MoE 스타일의 Shared Expert를 사용했습니다. Shared Expert의 사용이 꽤 의미 있는 디자인인 것 같긴 하네요.

#diffusion #moe